Что такое дубли страниц? Это разные страницы одного сайта с идентичным или почти идентичным контентом. С первого взгляда может показаться, что дубли не создают больших проблем. Но это ошибочное мнение. Пользователь действительно не заметит разницы, а вот для ранжирования ресурса в поисковых системах наличие страниц-дублей может иметь негативные последствия.

Какие сложности могут возникнуть при наличии большого числа дублей на сайте:

- Проблемы с индексацией. Поисковые роботы тратят время на индексацию страниц с дублирующим контентом и могут не проиндексировать действительно важные страницы вашего ресурса.

- Потеря внешнего ссылочного веса продвигаемых страниц. Как она возникает? Например, если пользователь поделился ссылкой не на продвигаемую страницу, а на ее дубль.

- Продвижение в поисковике нерелевантной страницы. То есть, когда поисковая система выдает ссылку не на ту страницу, которую вы продвигаете.

- Снижение уникальности контента ресурса.

- Риск попадания под фильтр поисковика из-за неуникального контента.

Дубли страниц бывают полными и частичными. Полные дубли имеют одинаковый контент (например, страницы с www и без www). В частичных дублях контент совпадает не на 100%, существуют отличия в отдельных элементах. Например, идентичный контент на карточках товаров интернет-магазина. Частичные дубли выявляются сложнее, к резким “проседаниям” в ранжировании они не приводят, но понижают позиции постепенно.

Как дубли могут возникнуть на сайте? Например, вследствие изменения структуры сайта, когда старым страницам присвоили новые адреса, но аналогичные страницы со старыми адресами сохранились. Также дубли могут быть сгенерированы CMS автоматически.

Как найти дубли страниц на сайте

Разберем разные способы.

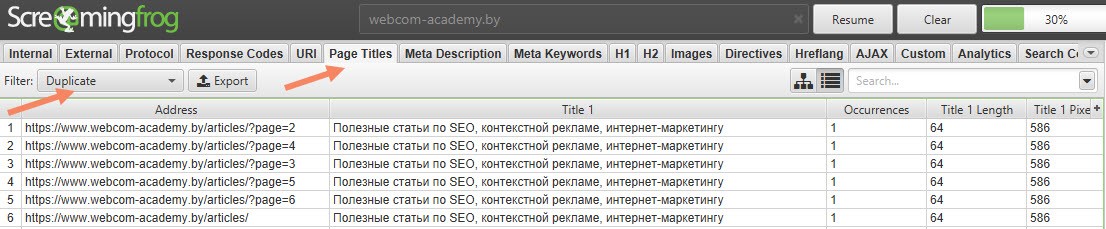

1. С помощью сканирования сайта специальными программами

О каких программах идет речь? Например, NetPeak Spider, Xenu Link Sleuth, Screaming Frog SEO Spider. Некоторые из них бесплатные (например, Xenu Link Sleuth), некоторые — частично или полностью платные. После сканирования сайта программой и выгрузки списка URL-ов, вы сможете провести сортировку по совпадению тега «Title» или «Description», обнаружив страницы с совпадающим контентом.

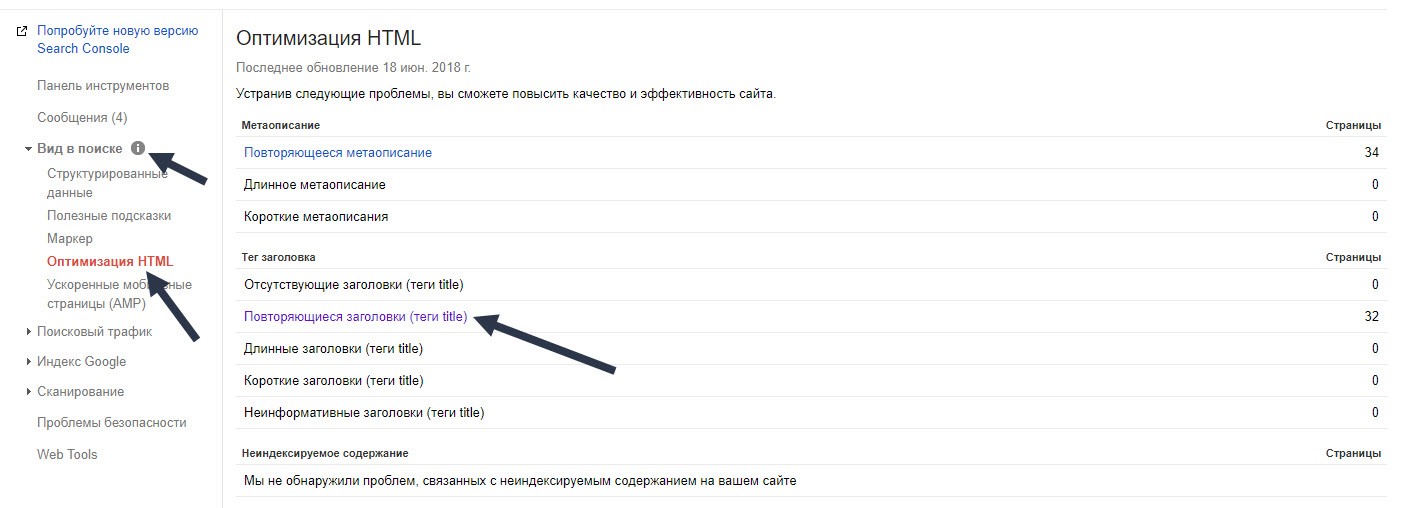

2. С помощью вебмастеров Гугл и Яндекс

Как найти дубли в поисковой консоли Google:

- заходим в панель инструментов;

- выбираем «Вид в поиске»;

- переходим по ссылке «Оптимизация html».

Дубли будут видны в пунктах «Повторяющееся метаописание» и «Повторяющиеся заголовки (теги title)».

В Яндекс Вебмастере дубли страниц на сайте можно обнаружить с помощью раздела «Страницы в поиске». Проходим по пути “Страницы в поиске -> Исключенные страницы -> Сортировка: Дубль -> Применить” и получаем список страниц-дублей. При необходимости данный список вы сможете выгрузить из Яндекс Вебмастера.

В целом первые два способа схожи, однако зачастую с помощью вебмастера можно найти дубли, которые не покажет вам программа, по причине отсутствия ссылок на них на сайте.

3. “Ручной” поиск

Поиск дублей вручную доступен опытным веб-мастерам. Специалист довольно быстро сможет определить наличие страниц с дублирующим контентом, попробовав разные вариации URL-адресов. Например, http://www.apteki.by/ и http://www.apteki.by////////.*

*мы берем условные адреса

4. С помощью оператора «site:»

Чтобы применить этот метод, необходимо ввести запрос «site:mysite.net» в поисковую строку ПС. Он выведет страницы сайта в общем индексе. Посмотрев выдачу, вы обнаружите страницы-дубли, а также страницы, содержащие разного рода “мусор”.

Как удалить с сайта дубли страниц

Чтобы не приходилось постоянно тратить время на выявление и закрытие от индексации страниц-дублей на сайте, можно избавиться от них. Как?

Существует несколько способов.

1. Настройка 301 редиректа в файле .htaссess.

Этот способ хорошо подойдет в случае, если дубли имеют точечный характер. Например, возникают из-за проблем с использованием слешей в URL. Так, 301 редирект можно использовать для перенаправления со страницы http://mysite.by/catalog///phone на страницу http://mysite.by/catalog/phone.*

*мы берем условные адреса

2. Запрещение индексации дублей в файле robots.txt.

Вы можете с помощью директивы «Disallow» запретить поисковым роботам доступ к определенным страницам:

User-agent: *

Disallow: /stranica

Этот метод стоит использовать для служебных страниц, которые дублируют контент основных страниц ресурса. Однако данный способ не всегда может сработать. К примеру, если страницы уже попали в индекс, то они все равно могут обнаружиться в выдаче.

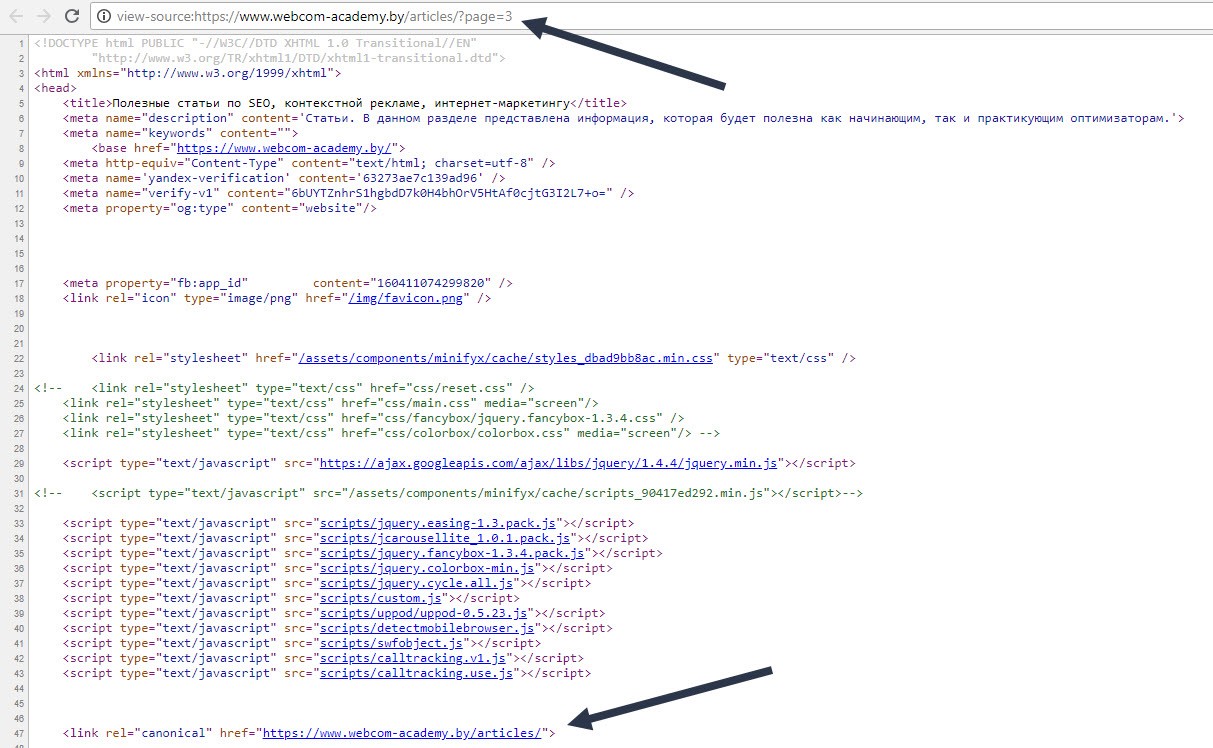

3. Установка тега rel=canonical на дубликатах страниц

Этот метод стоит использовать, если страницу необходимо оставить доступной для просмотра. Это характерно, например, для страниц фильтров и сортировок, UTM-страниц.

Указывая данный атрибут, мы обозначаем страницу, которая приоритетна для индексирования. Чтобы задать каноническую страницу, необходимо добавить в теге <link> атрибут rel=canonical в HTML-код текущей страницы.

Так, для страницы http://mysite.by/example/page2 канонической будет страница http://mysite.by/example/. В HTML-коде это будет отображается следующим образом: <link rel=canonical href=http://mysite.by/example/>.

4. Установка мета-тега <meta name=robots content=noindex, nofollow> или <meta name=robots content=noindex, follow>

Метатег <meta name=robots content=noindex, nofollow> дает роботу прямую команду не индексировать документ и не переходить по ссылкам. Метатег <meta name=robots content=noindex, follow> также дает команду не индексировать документ, но разрешает переходить по ссылкам.

Это решение подойдет, например, для вкладок с отзывами на товары. Тег размещается на страницах-дублях в блоке <head>: <meta name=robots content=noindex, nofollow />.

После удаления дублирующего контента желательно еще раз провести проверку сайта и вообще повторять ее регулярно, чтобы не терять позиции в выдаче и трафик на сайт. Конечно, небольшое число страниц с дублирующим контентом может не привести к неприятным последствиям, но если их много — ситуацию нужно обязательно исправлять.

|

Статью подготовил Дмитрий Медведев, ведущий спикер Webcom Academy. |